Hintergrundthemen

Antifragilität

Das Konzept der Antifragilität beruht auf Nassim Taleb und seinem Buch „Antifragilität – Anleitung für eine Welt, die wir nicht verstehen“.

(Dieser Beitrag muss noch aufgebaut werden. Daher ein paar kurze Auszüge aus dem Buch)

Es ist sehr viel leichter, sich zu überlegen, ob eine Sache fragil ist, als das Eintreten eines für diese Sache potenziell gefährlichen Ereignisses vorherzusagen. Fragilität ist messbar; Risiken sind nicht messbar.

Es ist viel einfacher Antifragilität aufzuspüren, als Vorhersagen zu treffen und die Dynamik von Ereignissen zu verstehen. Aus diesem Grund reduziert sich die Aufgabe darauf, das zentrale Prinzip zur Minimierung der Schäden von Prognose-Irrtümern herauszuarbeiten, sich als auf Bereiche zu konzentrieren, die nicht scheitern, sondern im Gegenteil womöglich sogar davon profitieren, wenn wir einen Fehler machen.

Die Fragilität, die als Folge einer Pfadabhängigkeit auftritt, wird häufig von Geschäftsleuten ignoriert, welche aufgrund ihres soliden Trainings in statistischem Denken zu der Überzeugung neigen, ihre oberste Mission bestehe darin, Profit zu machen, und Überleben und Risikokontrolle seien etwas, das man vielleicht irgendwann einmal in Betracht ziehen könnte – sie übersehen, dass Überleben dem Erfolg logisch unbedingt vorgeordnet ist.

Wir wissen wesentlich besser, was falsch, als was richtig ist, oder – formuliert vor dem Hintergrund der Fragil/Robust-Klassifikation – negatives Wissen (Was ist falsch? Was funktioniert nicht?) ist robuster gegen Irrtümer als positives Wissen (Was ist richtig? Was funktioniert?). Wissen wächst also wesentlich eher durch Subtraktion als durch Addition: Was wir heute wissen, kann sich morgen als falsch erweisen, aber etwas, von dem wir wissen, dass es falsch ist, kann sich nicht – jedenfalls nicht so ohne Weiteres – als richtig herausstellen.

Truthan-Problem: Der Schaden liegt in der Zukunft, nicht in der sauber definierten Vergangenheit.

Wir müssen Redundanz einbauen, einen Sicherheitspuffer, indem wir Optimierung vermeiden und Asymmetrien in unserer Risikoanfälligkeit abmildern, wenn nicht gar ganz entfernen.

Antizipation

Antizipation ist in der Psychologie und Soziologie die vorwegnehmende gedankliche Erwartung oder Erwartungshaltung. Ein Ereignis zu antizipieren heißt, in Betracht zu ziehen, dass ein Ereignis eintreten kann. Wikipedia

Die beste Vorbereitung auf unerwartete Ereignisse ist die geistige Beschäftigung mit der Tatsache, dass die Ereignisse überhaupt eintreten können. Wer in der Lage ist, ein unerwartetes Ereignis oder auch eine unangenehme Situation gedanklich durchzuspielen und die Handlungsalternativen vorab durchzudenken, ist in der Situation besser vorbereitet. Daher: Wie gehe ich persönlich mit subjektiver Unsicherheit um? Thomas Müller, Kriminalpsychologe

Antizipation ist daher auch für die Blackout-Vorsorge ganz besonders wichtig! Auch hier müssen Dinge durchgedacht werden, wofür es kaum Erfahrungswissen gibt. Im Sinne von Resilienz geht es dabei vor allem um ein Lernen vor dem Ereignis, also einer Vorwegnahme von möglichen negativen Entwicklungen. Dies aus einem ganz einfachen Grund: Das Erfahrungslernen aus einem Blackout ist unbezahlbar und daher unbedingt zu vermeiden.

Autarkie/Autarkiegrad

Autarkie im allgemeinen Sinne bedeutet, dass Organisationseinheiten oder Ökosysteme alles, was sie ver- oder gebrauchen, aus eigenen Ressourcen selbst erzeugen oder herstellen. Autarke Systeme sind u. a. wirtschaftliche Einheiten (Volkswirtschaften, Wirtschaftsregionen, Haushalte), die sich ausschließlich mit eigenen wirtschaftlichen Gütern (Lebensmittel, Rohstoffe, Waren, Dienstleistungen, Produktionsfaktoren), Energie (Inselsystem) versorgen und von Importen unabhängig sind.

Als Autonomie bezeichnet man den Zustand der Selbstbestimmung, Unabhängigkeit (Souveränität), Selbstverwaltung oder Entscheidungsfreiheit.

Daraus lässt sich sehr rasch erkennen, dass hier wohl der falsche Begriff verwendet wird. Das was häufig erreicht werden soll, ist wohl Autonomie!

Eine Energieautarkie ist nur dann gegeben, wenn ein reines Inselnetz/-versorgung betrieben wird, etwa auf einer Almhütte. Auch eine Energieautarkie übers Jahr gerechnet gibt es nicht, da ja weiterhin auf externe Ressourcen zurückgegriffen werden muss. Ganz abgesehen davon, dass im Stromversorgungssystem zu jedem Augenblick das Gleichgewicht zwischen Erzeugung und Verbrauch hergestellt sein muss, damit das System überhaupt funktioniert. So produziert zwar das Burgenland mehr Strom, als die BürgerInnen in einem Jahr verbrauchen. Das Burgenland wäre jedoch das ganze Jahr finster, gebe es nicht dahinter das österreichische/europäische Verbundsystem, dass auch für die notwendige Stabilität sorgt.

Zum anderen möchten wir auch darauf hinweisen, dass wenn jemand auch zu 60 oder sogar 99 Prozent eigenversorgungsfähig ist, er wahrscheinlich dennoch erwartet, dass er den restlichen Teil – bei 99 Prozent immerhin noch fast 90 Stunden des Jahres – eine funktionierende stabile Stromversorgung zur Verfügung hat. Es ist zwar verständlich, dass jene dafür nur wenig bezahlen wollen, da sie ja den Rest selbst stemmen, aber das kann nicht funktionieren, wenn man nur die tatsächlichen Energiekosten dafür berechnet (siehe auch Überlegungen zum Netznutzungsentgelt). Denn das teure Restsystem muss ja nicht nur in den 90 Stunden, sondern während der gesamten 8.760 Stunden zur Verfügung stehen, um jederzeit einspringen zu können. Das wird leider häufig vergessen.

Die Energie-/Stromversorgung wird daher auch in Zukunft nur als Gemeinschaftsaufgabe sinnvoll zu bewerkstelligen sein, aber kleinteiliger und dezentraler in Form von Energiezellen.

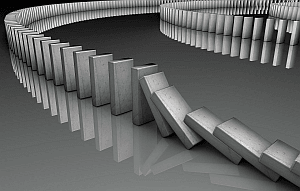

Domino-, Schneeball-, Kaskadeneffekt oder Kettenreaktion

Foto Lawine: Scientif38/Wikipedia

EVA: Studie "Ernährungsvorsorge in Österreich"

Ein breiter Wiederanlauf der Versorgung ist frühestens in der zweiten Woche (Phase 2) zu erwarten, wenn die Telekommunikationsversorgung wieder halbwegs stabil funktioniert und auch die internationalen Lieferketten wieder zu funktionieren beginnen.

Erst diese leichtfertige Ausgangssituation führt dann in eine wirkliche Katastrophe!

Exponentielle Entwicklung

grün = exponentielles Wachstum

rot = lineares Wachstum

blau= kubisches Wachstum

Quelle: Wikipedia

Ein Faktor, der häufig unterschätzt wird, sind exponentielle Entwicklungen. Dabei steigen ab einer bestimmten Größenordnung (siehe auch s-förmiges Wachstum) die Schäden bzw. die Wechselwirkungen rasant an. Damit steigt auch die Dynamik des Ereignisses. Eine „Beherrschung“ im herkömmlichen Sinne ist kaum möglich.

Zur Illustration dient folgende Legende: Der Erfinder des Schachspiels, Sissa, wünschte sich von seinem König folgende Belohnung. Für das erste Feld des Schachbrettes ein Korn, für das zweite zwei Körner, für das dritte vier Körner und bei jedem weiteren Feld doppelt so viele wie auf dem vorherigen Feld. Der König wunderte sich über die Bescheidenheit. Insgesamt wären dies jedoch mehr als 18 Trillionen Weizenkörner (oder rund 100 Milliarden LKW-Ladungen) gewesen, und sämtliche Welternten seit Beginn des Getreideanbaus hätten hierzu nicht ausgereicht. Die Legende drückt die Schwierigkeit aus, das Wachstum von Exponentialfunktionen richtig einzuschätzen. Auch bei der Zinseszinzentwicklung im Finanzsystem bzw. bei den Kreditzinsen kommt ein exponentielles Wachstum zum Tragen.

Kausalität versus Korrelation

Unser Gehirn ist dafür ausgelegt, Muster zu vervollständigen und wieder zuerkennen. Das bedeutet, das Gehirn versucht Eindrücke mit bereits bekannten und „gespeicherten“ Eindrücken zu vergleichen und zu kombinieren und eine Einordnung durchzuführen. Das ermöglicht schnellere Entscheidungen. Aber das kann genauso gut zu Falscheinschätzungen führen. Das führt dann auch zu bekannten optischen Täuschungen. Dieser Sachverhalt ist wichtig, um auch den Unterschied zwischen Kausalität und Korrelation zu verstehen. Denn wir Menschen neigen dazu, auch dort Zusammenhänge (Kausalität) zu sehen, wo es keine gibt. Siehe etwa das Video https://youtu.be/L5QHyL823Xw.

Kausalität (Ursache oder Wirkungsbeziehung)

Kausalität (lateinisch causa, „Ursache“) ist die Beziehung zwischen Ursache und Wirkung, betrifft also die Abfolge aufeinander bezogener Ereignisse und Zustände. Demnach ist ein Ereignis oder der Zustand A die Ursache für die Wirkung B, wenn B von A herbeigeführt wird. (Quelle: Wikipedia)

Kausalkette Beispiel: Dominosteine: Das Umfallen des ersten Steins bewirkt das Umfallen des zweiten Steins; dieses Umfallen bewirkt wiederum das zeitlich darauffolgende Umfallen des dritten usw. – bis der letzte Stein umgefallen ist.

Siehe auch das Video: https://youtu.be/lvKLsTTVzb4

Korrelation („Wechselbeziehung“)

Eine Korrelation (mittellat. correlatio für „Wechselbeziehung“) beschreibt eine Beziehung zwischen zwei oder mehreren Merkmalen, Ereignissen, Zuständen oder Funktionen. Die Beziehung muss keine kausale Beziehung sein: manche Elemente eines Systems beeinflussen sich gegenseitig nicht, oder es besteht eine stochastische, also vom Zufall beeinflusste Beziehung zwischen ihnen (Quelle: Wikipedia).

Das bedeutet, dass Verhalten ist rein zufällig oder entsteht über eine weitere Variable, die häufig nicht wahrgenommen wird. Wir Menschen neigen jedoch dazu, darin eine Kausalität – also eine Wirkungsbeziehung – zu erkennen, was zu falschen Rückschlüssen und Entscheidungen führen kann.

Korrelation vs. Kausalität: So lassen sich Statistiken manipulieren

Siehe auch das Video: https://youtu.be/YgFJRrvp3Nc oder APL 031: Warum leben verheiratete Männer länger? Der Unterschied zwischen Korrelation und Kausalität

Momentanreserve (rotierende Masse)

Dieser Energieanteil im Gesamtsystem wird „Momentanreserve“ genannt. Im ersten Moment eines solchen Ausfalles ändern sich also nur die Energieanteile. Das führt instantan (also sofort und ohne weitere Maßnahmen) zu Änderungen der Drehzahl aller am Netz befindlichen Synchrongeneratoren. Das ist keine „Dämpfung“ der Frequenz, sondern die Folge des Änderns der Energieanteile. Diese Änderung der Drehzahl gleicht die gestörte Leistungsbilanz so lange aus, bis wieder die durch den Ausfall fehlende Leistung durch die Wirkung der Primärregelung ersetzt werden kann. Die Frequenz ist bei Synchrongeneratoren übereinstimmend mit der Drehzahl und ein Abbild der Systemstabilität.

Damit ist die Frequenz des erzeugten Wechselstromes die Kenngröße für die Leistungs-Frequenz-Regelung. Der Unterschied von der gemessenen Frequenz zur Sollfrequenz (50 Hz im europäischen Stromsystem) ist der Maßstab für die Primärregelung, die so rasch wie möglich den Abfall der Drehzahl durch zusätzliche Energieeinspeisung (positive Regelenergie) stoppen soll. Diese zusätzlich notwendige Energieeinspeisung kann auch durch Batteriespeichersysteme geliefert werden (siehe etwa die Großstörung in UK am 09.08.19). Dazu muss die aktuelle Frequenz und die Sollfrequenz bekannt sein und die den Batteriesystemen zu entnehmende Leistung bestimmen. Dann erst folgen weitere Maßnahmen, welche die abgefallene Drehzahl wieder auf Nenndrehzahl bringen.

Die gesamte Regelung ist demnach ein relativ komplexer Vorgang, der nur im Einklang mit den Naturgesetzen beherrscht werden kann. „Flexibilität“ reicht dafür nicht aus! Das Thema „Stabilität darf im Übrigen nicht nur auf Energiemangelsituationen beschränkt werden. Auch Energieüberschuss (negative Regelleistung) muss in gleicher Weise beherrscht werden. Immer ist die Frequenz der Dreh- und Angelpunkt.

Der Beitrag zur Momentanreserve ist von der elektrisch erzeugten Leistung eines Kraftwerks (mit einem Synchrongenerator) unabhängig. Dieser Beitrag ist nur von der Masse und der Drehzahl des Synchrongenerators abhängig. Die elektrische Leistung ist das Ergebnis einer „Transformation“ der in die fest verbundenen Turbine einspeisende (mechanische) Leistung aus dem einströmenden Dampf des angeschlossenen Kessels. Wenn mehr elektrische Leistung benötigt wird, dann muss der Dampf „aufgedreht“ werden. Das wäre z.B. die Konsequenz eines Regeleingriffs. Der Synchrongenerator dreht sich immer mit der im gesamten Netz gerade aktuellen Frequenz und das ist unabhängig von der abgegebenen elektrischen Leistung. Das gilt für alle im Wechselstromsystem insgesamt einspeisenden Kraftwerken mit Synchrongeneratoren.

Bei einem Lastsprung reagieren alle Synchrongeneratoren gemeinsam durch ein Absenken der Drehzahl, um die momentan fehlende Leistung auszugleichen. Dadurch wird der Momentanreserve Energie (Rotationsenergie der Synchrongeneratoren) entzogen und diese Energie wechselt inhärent und instantan in den elektrischen Systemteil. Siehe mein Bild mit dem Pendel und der gedanklichen Aufteilung der Gesamtenergie des Pendels in Lage- und Bewegungsenergie. Diese Aufteilung ist eine Gedankenkonstruktion. Die Natur trennt nicht die Energie. Wir Menschen trennen die Energie durch unsere gedankliche Aufteilung. Dieses Aufteilen ist eine Fiktion. Deshalb auch die Verwendung der Worte inhärent und instantan. Im ersten Moment eines Lastsprungs bleibt die Gesamtenergie des Gesamtsystems konstant. Wenn nicht nachgeregelt wird, fließt entsprechend dem Lastsprung die zusätzlich angeforderte Energie aus dem System ab. Im ersten Moment stammt diese Energie vollständig aus der Momentanreserve und damit aus alle im Netz befindlichen Kraftwerken.

Erst eine zusätzliche Einspeisung der Primärregelung gleicht aus und übernimmt die Einspeisung der zusätzlich angeforderten Energie. Dann ist aber die Drehzahl bereits abgefallen. Durch die Zusatzeinspeisung (Primärregelleistung) wird ein weiteres Abfallen der Drehzahl und damit der Frequenzrückgang gestoppt. Schließlich muss die zusätzlich einspeisende Sekundärregelleistung im betroffenen Regelbereich versuchen, die Drehzahl wieder auf den Sollwert zu bringen. Das erst bringt die Momentanreserve wieder auf ihren ursprünglichen Energieinhalt zurück. Und das verteilt sich wieder auf alle Kraftwerke im Netz (die ja alle mit der gleichen Frequenz in Betrieb sind). Der zwischenzeitlich eingetretene Frequenzeinbruch ist Kennzeichen eines „Energielochs“. Das muss letztlich auch noch im betroffenen Regelbereich durch weitere Einspeisungen „aufgefüllt“ werden. Das ist wie eine Rücklieferung der Primärregelleitungsbeiträge an alle, die mitgeholfen haben, den Lastsprung auszuregeln. Damit wird letztlich auch wieder die Synchronzeit der amtlichen Uhrzeit angeglichen, denn der Frequenzeinbruch hat die Synchronuhren langsamer laufen lassen und die Synchronzeit hinkt der amtlichen Uhrzeit hinterher.

Damit kommt der Momentanreserve eine ganz zentrale und vor allem unverzichtbare Bedeutung für die Systemsicherheit des europäischen Stromversorgungssystems zu.

Unterschied zur Regelleistung

Siehe Wikipedia.

Quelle: Wikipedia

Was ist Momentanreserve?

Weiterführende Informationen

- Die Primärregelung verteilt Schwankungen des Stromverbrauchs auf Kraftwerke im gesamten Verbundsystem

- Gigabatterien sollen Stromnetz entlasten

- Wie bleibt unser Stromnetz stabil?

- Weckruf: Orchestrieren statt Steuern

- Wird die Versorgungssicherheit wirklich ausreichend berücksichtigt?

- System-Robustheit – Physik als verlässliche Grundlage

- Die Energiebevorratung als unverzichtbarer Bestandteil der Energiewende

- Das europäische Stromversorgungssystem

- Gleichzeitigkeitsfaktor bei Leistungsänderungen

Anmerkungen Franz Hein: Ersatz durch Leistungselektronik

Das mit der Momentanreserve wird mehr und mehr zum heißen Eisen, weil es (Fach?)Leute gibt, die felsenfest der Überzeugung sind, dass mit einer schnellen P(f)-Regelung (mittels Leistungselektronik) die Bedeutung der Momentanreserve abnimmt bzw. diese ganz ersetzt werden kann. Man meint, dass eine genügend schnell reagierende Leistungselektronik so rasch wieder das Leistungsgleichgewicht herstellen kann, dass damit Lastsprünge beherrschbar bleiben. Es ist nur so, dass auch da die Frequenz als Kenngröße unverzichtbar ist, dass sie gemessen werden muss, dass eine beliebig genaue Frequenzmessung Zeit braucht und dass bei abnehmender Momentanreserve die Frequenz im Gesamtsystem immer „steiler“ auf einen Leistungssprung reagiert. Damit bleibt der „Schnellen“ P(F)-Regelung immer weniger Zeit für ihr Eingreifen. Das kann nicht ad infinitum so weiter getrieben werden.

Ich halte auch die schnelle P(f)-Regelung für einen großen Gewinn, nur braucht die eben doch die Momentanreserve, weil im Energieerhaltungssatz der eigentliche Hebel steckt und der inhärent erfolgende Energie“transport“ (eigentlich eine „Umbenennung“ von Energieinhalten) zwischen „mechanischem“ Energieinhalt in den Schwungmassen und dem „elektrischen“ Energieinhalt im Stromsystem sich in der Frequenz äußert und damit die Kenngröße für die Regelung erzeugt. Die Frequenz ist eben die ideale Kenngröße für das Ausregeln.

Weiter Anmerkung zum Artikel Vattenfall, Nordex und CC4E wollen mit erneuerbaren Energien Netze stabilisieren:

Zunehmend drängen erneuerbare Energien fossile Brennstoffe aus dem Energiemix und mit ihnen die rotierenden Massen, die das Netz stabilisieren. Energieversorger und Netzbetreiber sind daher auf der Suche nach preisgünstigen und erneuerbaren Alternativen. Ein neuer Ansatz von Vattenfall, Nordex Energy und CC4E will nun erneuerbare Energien in verlässliche Stabilisatoren verwandeln. Dafür installierten sie an einem 12,6-Megawatt-Windpark in Curslack in Norddeutschland einen Lithium-Batteriespeicher mit 720 Kilowatt Leistung und 792 Kilowattstunden Kapazität. Die Batterie ist aus Lithium-Ionen-Akkus aufgebaut, wie sie auch in Elektroautos verwendet werden. Batteriespeicher und Windpark interagieren mittels einer intelligenten Regeleinheit miteinander und speisen Strom in das öffentliche Stromnetz ein. Entscheidend dabei sei, dass die beiden Komponenten eine Einheit bilden und gemeinsam in den Netzanschlusspunkt einspeisen, betont Vattenfall. Mit dem Speicherregelkraftwerk sollen verschiedene Anwendungsfälle zur Spannungs- und Frequenzhaltung erprobt werden, wie auch die Bereitstellung lokaler Blindleistung, Redispatch und anderes. Dabei sollen die Systemdienstleistungen nicht nur nacheinander, sondern auch gleichzeitig (gestapelt) ausgeführt werden, was eine Neuheit darstelle.

Noch weiter in die Zukunft geblickt, versucht das Team auch die Momentanreserve zu ersetzen, wobei dafür bisher noch keine Geschäftsmodelle existieren. Da die benötigte Energie für Systemdienstleistungen wie die Momentanreserve künftig nicht mehr automatisch vorgehalten wird, muss nun erarbeitet werden, zu welchen Bedingungen sie zukünftig bereitgestellt und vergütet werden kann, schreibt Vattenfall.

Es ist sicher nicht verkehrt, dass Speicher für die Bereitstellung von Energie zum Ausregeln von Leistungsmangelsituationen eingesetzt werden. Auch nicht verkehrt ist, dass Speicher in Leistungsüberschusssituationen aus dem System Energie in die Speicher überführen. Aber das allein als Ersatz für die rotierenden Massen zu „verkaufen“, das ist falsch. Da liegt der Hund begraben. Es muss zunächst ein Leistungsungleichgewicht so erkannt werden, dass das zu einer Regelgröße führt. Ein Synchrongenerator stellt mit seiner rotierenden Schwungmasse eben exakt mit der Drehgeschwindigkeit und damit mit der erzeugten Frequenz des Wechselstromes die Kenngröße her, aus der sich das Leistungsungleichgewicht aufgrund von physikalischen Gesetzen ergibt. Dann erst ist für die Speicher diese Kenngröße nutzbar, um das System wieder in das Leistungsgleichgewicht zu überführen.

Das Leistungsungleichgewicht kann natürlich auch durch die Bestimmung des Randintegrales erfolgen. Das aber setzt eine quasi gleichzeitig erfolgende und entsprechend genaue Messung der Leistung an allen Übergabestellen am Rand einer Energiezelle voraus. Bei mehreren Übergabestellen ist das sehr schwer machbar. Die Thematik der Gleichzeitigkeit von Messungen führt immer zu Überlegungen, in denen die küpfmüllersche Unbestimmtheitsrelation greift. Siehe bei Wikipedia: Um eine Frequenz von 1 Hz zu bestimmen, muss das Signal mindestens 1 s lang gemessen werden.

Zu all dem kommt noch folgendes: Jede Messung kostet Zeit. Jede Informationsübertragung auch. Aber auch die Energiezufuhr (bei Leistungsmangel) und das Wegspeichern von Energie (bei Leistungsüberschuss) braucht Zeit. Wenn das System schneller instabil wird, als die vorgenannten Maßnahmen greifen, dann ist der Weg in die Instabilität nicht mehr aufzuhalten. Das Energiesystem hat einen Kipppunkt. Wird der überschritten, dann führt kein Weg mehr zurück. Da hilft dann auch keine Leistungselektronik nicht mehr.

Wir haben es bei diesem Thema mit der Notwendigkeit des Sowohl-als-auch-Denkens zu tun. Wir brauchen eine Kenngröße. Um diese zu erhalten brauchen wir Zeit. In dieser Zeit bewegt sich das System weiter aus dem Ungleichgewicht heraus. Dann brauchen wir rasch reagierende Stützungsmaßnahmen. Je rascher diese reagieren, um so eher kann die Bewegung aus dem Ungleichgewicht gestoppt werden. Ein System, das keine Momentanreserve mehr hat, bewegt sich beliebig schnell aus dem Ungleichgewicht. Dann kann auch eine noch so rasch reagierende Stützungsmaßnahme nicht mehr greifen.

Ich bleibe dabei: Wir brauchen eine ausreichende Energiepufferung in den rotierenden Massen, damit die erzeugte Frequenz bei einem Leistungshub sich so „langsam“ verändert, dass eine „schnelle“ Regelung in den Gleichgewichtszustand wieder zurückführen kann. Die rotierenden Massen müssen nicht in konventionellen Kraftwerken installiert sein. Es genügen am Netz zugeschaltete Synchrongeneratoren mit insgesamt ausreichender Speicherung „mechanischer“ Energie. Dann folgt aus dem Satz der Erhaltung der Energie in einem abgeschlossenen System „automatisch“ der inhärent ablaufende Prozess einer Neuverteilung der Energieanteile.

Zusätzliche Anmerkung: Auch hier befinden wir uns am Beginn einer Testphase mit wahrscheinlich negativem Ausgang. Die erforderlichen Ersatzlösungen müssten aber bereits jetzt installiert werden. Als Draufgabe wird dann auch noch mit „es gibt dafür keine Geschäftsmodelle“, obwohl ohne Momentanreserve das System gar nicht funktioniert!

Ergänzungen 27.07.20: UK – How our new spin on grid stability is a boost for renewable generation

Was nun noch fehlt, ist die Beschränkung einer Leistungsveränderung in Abhängigkeit von der im System vorhandenen Momentanreserve. Je größer dieser Energiepuffer ist, umso langsamer ändert sich die Frequenz, d.h. der Frequenzgradient ist geringer. Das gibt dem anschließenden Regelungsprozess mehr Zeit. Zeit braucht dieser Regelungsprozess in jedem Falle, denn zunächst muss die Frequenz gemessen und eine Frequenzänderung erkannt werden. Dann muss die Leistungselektronik den Energiestrom vom bzw. zum Batteriespeicher aktivieren („vom“ bei erkannten Leistungsmangel = Frequenzabsenkung, „zum“ bei erkannten Leistungsüberfluss = Frequenzerhöhung). Für die Beschränkung der Leistungsveränderungen habe ich den Systemschutz als zusätzliche Schutzeinrichtung vorgesehen. Hier besteht eine dynamische Beziehung zur aktuell vorhandenen Momentanreserve. Das ist ganz besonders wichtig bei einem Systemwiederaufbau. Bisher gibt es den Systemschutz nicht. Wie er realisiert werden kann, ist mir noch ein Rätsel. Besonders das „Verteilen“ in Richtung unterlagerten Hierarchie-Ebenen muss durchdacht werden. Problem ist die Gleichzeitigkeit von Leistungsveränderungen in einem ausgedehnten System.

Diese Beschränkung der Leistungsveränderung gilt für das Gesamtsystem. Damit gilt das auch für den Ausfall einer Einspeisung bzw. dem Abschalten eines Verbrauchers. Heute ist diese Größenordnung auf 3000 MW im mitteleuropäischen Regelbereich festgelegt. Diese Festlegung geht aber von der bisher vorhandenen Momentanreserve aus. Wird diese abgebaut, dann muss sich diese Größe ändern, weil sonst die Primärregelung die Leistungsveränderung nicht verkraftet. Durch die neuen Technologien wird der oben erwähnte Zeitbedarf deutlich kürzer. Das erlaubt in gewissen Grenzen einen Abbau der Momentanreserve – aber keineswegs auf null. Je mehr Momentanreserve abgebaut wird, umso verletzlicher wird das Gesamtsystem. Damit sinkt die Robustheit. Genauso wie eine Mindestreserve bei der Energiebevorratung notwendig wird und auch ein Leistungs“puffer“ brauchen wir eine Mindest-Momentanreserve. Diese legt dann den maximalen Leistungshub fest. Das sind vier gesellschaftlich wichtige Festlegungen, die keinesfalls „dem Markt“ überlassen werden dürfen. Hier sehe ich Handlungsbedarf. Ich werde nun doch noch für meinen Vortrag in Bremen mindestens eine weitere Folie erstellen müssen, um diese vier Randbedingungen aufzuzeigen.

Der Primär-Regelvorgang muss so lange andauern, bis die Frequenzänderung gestoppt ist. Damit ist die Primärregelung beendet, an der sich alle Primärregel-Einheiten im gesamten System beteiligen. Danach startet die Sekundärregelung in dem vom Leistungshub betroffenen Regelgebiet. Darin erfolgt der Ausgleich solange, bis die Frequenz wieder auf den Sollwert gebracht ist. Heute ist der dafür erlaubte Zeitbereich eine Viertelstunde. Infolge der neuen Technologien kann an dieser Zeitfestlegung „gedreht“ werden, denn bisher waren Wärmekraftwerke und ihre Änderungsgeschwindigkeiten maßgebend.

‘Digital inertia’: Energy storage can stabilise grid with 1/10 the capacity of thermal generation

Inertia is a system-wide service that responds to fluctuations in electricity frequency in the first fraction of a second of an imbalance between supply and demand – for example, when a power station suddenly drops offline. Traditionally, this stabilising hand has come from the kinetic energy provided by the spinning mass of (synchronous) generators that produce electricity from fossil fuels.

Es braucht die kinetische Energie der Rotoren von Synchronmaschinen, damit die so entstehende Drehzahländerung und so die Frequenzänderung als Regelgröße genutzt werden kann. Die Synchrongeneratoren müssen dazu keinesfalls mit fossilen Rohenergien angetrieben werden. Wichtig ist die Schwungmasse, nicht der Antrieb. Dann kann mit anderen Technologien aufgrund der Frequenzänderung eingegriffen werden. Mittels Batteriespeicher und Leistungselektronik ist das möglich – siehe den Vorfall am 9.8.2019 in Großbritannien. Das heißt, wir brauchen so viel Schwungmasse in Synchronmaschinen, dass der aufgrund eines Leistungshubs entstehende Frequenzgradient durch andere Technologien beherrscht werden kann. Deren Reaktion am 9.8.2019 war extrem schnell, schneller als es bisherige Regelkraftwerke können, sogar schneller als Pumpspeicherwerke. Allerdings braucht es nicht nur Schnelligkeit, sondern auch Regelleistung und damit Regelenergie. Langsamere Technologien müssen dann die Batteriespeicher ablösen. Wir brauchen hier ein Miteinander von Physik und Informatik. Das ist dann keine „digitale inertia“, sondern eine Symbiose von analogem und digitalem Vorgehen. Eine Kombination von Synchronmaschinen als Schwungmassenspeicher, Batteriespeicher mit Leistungselektronik und Pumpspeicherwerke würde die heutige Regelung ablösen. Deshalb rate ich ja beim Abbau der heutigen Wärmekraftwerke die Synchrongeneratoren beizubehalten. Sie müssten dann allerdings auch von den Turbinen getrennt werden, die heute für ihren Antrieb sorgen. Es wären dann keine Synchrongeneratoren, sondern Synchronmaschinen, deren Schwungmasse als Energiespeicher genutzt wird. Wärmekraftwerke für die Regelung wären dann tatsächlich (langfristig) unnötig. Ich vermute aber, dass noch längere Zeit mit Gaskraftwerken zusätzlich geregelt werden muss, weil sonst die Regelleistung und die Regelenergie nicht ausreicht. Aber so wäre ein evolutionärer Übergang möglich, bei dem nach und nach Gaskraftwerke entfallen können, wenn genügend Batteriespeicher und Pumpspeicher zusätzlich zur Momentanreserve (Inertia) vorhanden sind.

(N-1)-Sicherheit

Diese Simulationsrechnung ist eine der wesentlichen Grundlagen für die Systemführung, sowohl in präventiver Hinsicht als auch zur Ergreifung kurativer Maßnahmen. Die Simulationen werden alle fünf Minuten wiederholt.

Phasen eines Blackouts

Um die tatsächlichen Auswirkungen eines Blackouts erfassen zu können, muss das Gesamtszenario betrachtet werden. Die meisten Menschen denken nur an einen Stromausfall, also an die

- Phase 1. Das greift jedoch deutlich zu kurz und führt zu einer massiven Unterschätzung. Denn auch in der

- Phase 2, also wenn noch kaum ein Telefon, Handy oder das Internet funktionieren, wird auch sonst kaum etwas funktionieren. Weder eine Produktion, Logistik noch Treibstoffversorgung. Auch kein Tanken oder Einkaufen. Nur die Wasserver- und Abwasserentsorgung sollten wieder funktionieren. Erst in der

- Phase 3 kann dann der Wiederanlauf der Versorgung mit lebenswichtigen Gütern beginnen. Und das kann dauern. Denken Sie nur an mögliche Ausfälle in der industrialisierten Tierhaltung oder Glashausproduktion. Es wird zum Teil Jahre dauern, bis sich wieder eine Normalisierung einstellt.

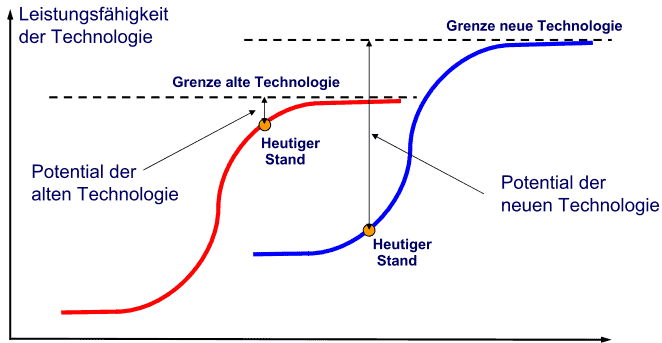

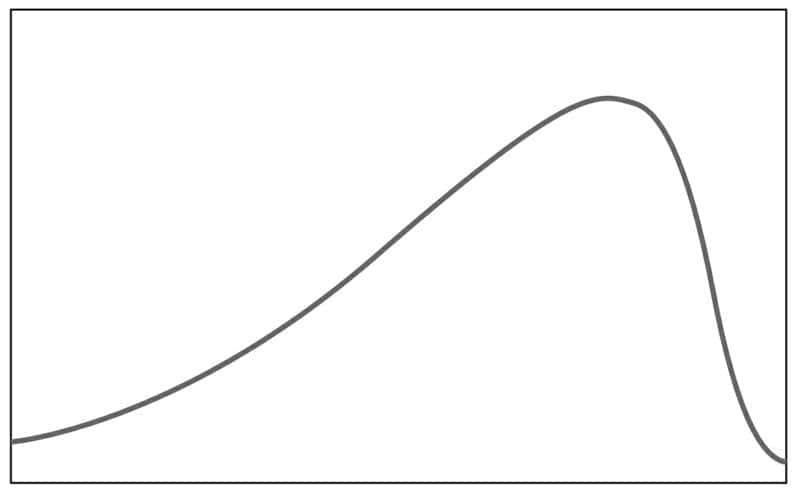

s-förmiges Wachstum

Eine wichtige Rolle bei diesen Anpassungszyklen spielt das universelle s-förmige Wachstum. In der Natur findet man nur ein s-förmiges Wachstum. Eine Weiterentwicklung erfolgt immer durch eine Adoption. Der einzige Gegenversuch – der medizinische Krebs – ist bislang erfolglos geblieben. Die künstliche Hinauszögerung einer Anpassung und das Festhalten am Wachstum führte bisher immer zum Kollaps. Siehe hierzu etwa auch unter dem Tag The Limits to Growth“.

(c) Frederic Vester/Eigene Darstellung

Dieses s-förmige Wachstum kann auch in der Wirtschaft beobachtet werden. Beispielsweise: Festnetztelefone – Mobiltelefone – Smart-Phone; Die Anpassungszyklen wurden dabei immer kürzer.

Auch in vielen anderen Bereichen kann man diese zyklischen Entwicklungen beobachten. Vieles deutet darauf hin, dass wir uns derzeit am Beginn des 6. Kondratieff-Zykluses befinden. Auch die Entwicklung der Netzwerkgesellschaft scheint den exponentiellen Ast erreicht zu haben, somit steigt die Geschwindigkeit und Dynamik der Veränderungen, also die Turbulenzen.

"Schmetterlingseffekt" - Kleine Ursache, große Wirkung

Gerade in komplexen Systemen können kleine Veränderungen zu ganz großen und meist nicht vorhergesehenen Entwicklungen/Nebenwirkungen führen. Aber auch umgekehrt, große Anstrengungen und Ressourcenaufwände führen zu keinen Ergebnissen.

Die Chaosforschung macht darauf aufmerksam, dass entgegen dem Kausalitätsprinzip gleiche Ursachen nicht gleiche Folgen haben müssen und kleine Änderungen unverhältnismäßig weit reichende Folgen nach sich ziehen können (Schmetterlingseffekt). Demnach erlaubt keine noch so genaue Systemanalyse eine Prognose des künftigen Systemverhaltens.

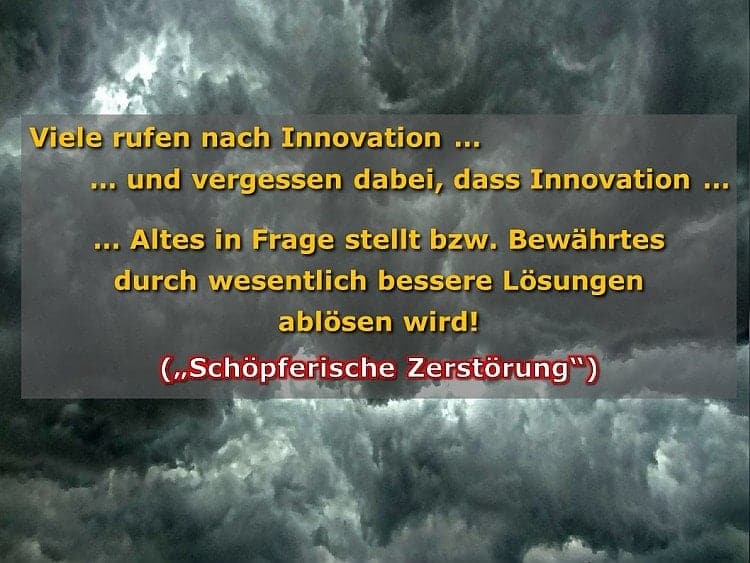

„Schöpferischen Zerstörung“ und Innovation

Ein Begriff aus der Makroökonomie, der vom österreichisch/amerikanischen Ökonomen Joseph Schumpeter entwickelt wurde. Die Kernaussage dazu lautet:

Jede ökonomische Entwicklung (im Sinne von nicht bloß quantitativer Entwicklung) baut auf dem Prozess der schöpferischen bzw. kreativen Zerstörung auf. Durch eine Neukombination von Produktionsfaktoren, die sich erfolgreich durchsetzt, werden alte Strukturen verdrängt und schließlich zerstört. Die Zerstörung ist also notwendig − und nicht etwa ein Systemfehler −, damit Neuordnung stattfinden kann. Quelle: de.wikipedia.org

Daher ist der Ruf nach Innovation auch immer ein zweischneidiges Schwert. Ob das den Rufern so klar ist, darf bezweifelt werden.

Schwarzer Schwan

- Antifragilität: Anleitung für eine Welt, die wir nicht verstehen. 2013

- Der Schwarze Schwan: Konsequenzen aus der Krise. 2012

- Der Schwarze Schwan: Die Macht höchst unwahrscheinlicher Ereignisse. 2007

Schwarze Schwäne führen zu strategischen Schocks / X-Events.

Wir sollten daher nicht zu selbstgefällig werden und uns um Achtsamkeit bemühen. Nicht das etwas schiefgehen kann ist schlimm, sondern wenn wir das ausschließen und uns nur darauf verlassen, dass schon nichts passieren wird. Einige wichtige Gedankenanstöße dazu liefert etwa das Buch „Das Unerwartete managen„.

Seneca-Effekt

Aus: Bardi, Ugo: Der Seneca-Effekt – Warum Systeme kollabieren und wie wir damit umgehen können. Erfurt: SEUME Publishing Services GmbH, 2017

»Der Seneca-Effekt« beschreibt ein Phänomen in komplexen Systemen, wonach diese zum Kollaps neigen, bzw. das eine Eigenschaft und kein Defekt ist, um eine Erneuerung sicherzustellen. Siehe dazu auch die „Schöpferische Zerstörung“ in der Ökonomie. Demnach gibt es immer einen langsamen Anstieg, der jedoch mit einem relativ abrupten Ende endet. Das kann sowohl bei Gesellschaften als auch in der Materialwissenschaft beobachtet werden.

„Die Tendenz komplexer Systeme zum Zusammenbruch lässt sich unter anderem unter dem Aspekt der »Kipppunkte« betrachten. Der Begriff verweist darauf, dass ein Kollaps kein sanfter Übergang ist, sondern eine drastische Veränderung, die das System von einem Zustand in einen anderen überführt („Phasenübergang“), wobei es kurzzeitig einen instabilen Zustand durchläuft.“ S. 14

„Tatsächlich ist der Seneca-Effekt meist die Folge des Versuchs, sich einer Veränderung zu widersetzen, statt sie anzunehmen. Je mehr Widerstand man gegen eine Veränderung leistet, desto mehr schlägt diese Veränderung zurück und überwindet schließlich diesen Widerstand. Und oft geschieht dies plötzlich. Letztlich ist dies das Ergebnis des zweiten Hauptsatzes der Thermodynamik: Die Entropie nimmt zu.“ S. 15

„Resilienz: die Akzeptanz des Unvermeidlichen.“ S. 209

Damit wird einmal mehr unterstrichen, dass Resilienz nicht nur ein neuer Modebegriff ist, sondern komplementär zu unserem heutigen Sicherheits- und Risikodenken zu sehen ist. Es geht nicht um die Verhinderung, sondern um die Bewältigung von nicht verhinderbarem! „Erholung ist die andere Seite von Resilienz: Ist ein Zusammenbruch unvermeidlich, kann man wenigstens versuchen, aus den Trümmern wieder aufzusteigen. Wie schwer oder einfach dies ist, liegt an der jeweiligen Struktur des Systems.“ S. 210f

Vertiefende Einsichten liefert die Buchzusammenfassung.

Sowohl-als-auch statt entweder-oder

Weiterführende Gedanken finden Sie dazu etwa auch im Blogbeitrag von Conny Dethloff: “Unser Denkrahmen hat sich seit dem Mittelalter nicht weiter entwickelt”

Strategische Schocks / X-Events

„Während eine Störung tendenziell häufiger, mit einer geringeren Destruktionskraft und einer längeren Verweildauer bei gleichzeitigem Systemfortbestand in Erscheinung tritt, ist ein Schock durch eine geringe und unregelmäßige Häufigkeit einhergehend mit einer hohen Existenzgefährdung des Systems gekennzeichnet. Beide Phänomene sind als krisenhafte Phänomene zu verstehen, die jeweils das Potential einer Veränderung hin zu einem katastrophischen Zustand beinhalten. Das hauptsächliche Unterscheidungskriterium zwischen einer Krise und einer Katastrophe ist das Vorhandensein von Kapazitäten und Ressourcen zur entsprechenden Zustandsbewältigung. Sind diese Bewältigungskompetenzen in einem adäquaten Ausmaß und Passungsverhältnis verfügbar, verbleibt das System noch in einem Zustand relativer Sicherheit – mangelt es an ihnen, verfällt es in einen katastrophischen Zustand, der mit jenem der Unsicherheit gleichzusetzen ist. Unter einer Krise soll daher ein Systemzustand verstanden werden, der durch Irritationen unterschiedlicher Qualität ausgelöst wird und mit einer Beeinträchtigung der Systemfunktionalitäten einhergeht. Die Verweildauer in einem solchen krisenhaften Zustand kann stark variieren, beeinflusst den Fortbestand des Systems jedoch nicht: Trotz eines zunehmenden Handlungsdrucks bei abnehmendem Handlungsspielraum sind insgesamt ausreichend Unsicherheitsbewältigungskapazitäten vorhanden, um das System in einen sicheren Zustand zurückzuführen. Eine Katastrophe als mögliche Entwicklungsform einer Krise ist im Vergleich dazu durch die zeitweise Nicht-Verfügbarkeit von Bewältigungsmechanismen gekennzeichnet. Die Dauer eines katastrophischen Zustands richtet sich danach, wie schnell eine (Wieder-)Herstellung von Handlungsfluidität gelingt;“ Daniela Giebel, Integrierte Sicherheitskommunikation, S 61f.

Siehe etwa auch

- Beyond data breaches: global interconnections of cyber risk bzw.

- X-Events von John Casti – Der plötzliche Kollaps von allem: Wie extreme Ereignisse unsere Zukunft zerstören können.

An X-Event is an extreme event that occurs in response to a shock that triggers a society to move rapidly from a point of apparent stability to a point of great uncertainty and instability. The society may have been stable and resilient enough to absorb many different types of shocks without triggering an X-Event. However, there may be other characteristics of a society that make it vulnerable to certain shocks, thus triggering an X-Event. - LOW probability, HIGH impact scenarios (HILP)

Systemische Risiken

Systemische Risiken sind durch vier wesentliche Merkmale gekennzeichnet:

- Es bestehen ein hoher Vernetzungsgrad und viele Interdependenzen zu anderen Systemen.

- Störungen können sich fast ungehindert im System und über (System-)Grenzen hinweg ausbreiten (grenzüberschreitende Auswirkungen).

- Durch Rückkoppelungen kommt es zu zufälligen und nicht-linearen Ursache-Wirkungsketten und kleine Ursachen können große Wirkung erzeugen („Schmetterlingseffekt„, stochastische Ursache-Wirkungsketten, Kipppunkte).

- Die Auslöser und Auswirkungen werden systematisch unterschätzt.

Damit widersprechen sie häufig dem intuitiven Verständnis von plausiblen Handlungszusammenhängen. Wissensangebote zu komplexen Phänomenen wie etwa zum Klimawandel oder zum Finanzmarkt wirken oft undurchsichtig und wenig nachvollziehbar.

Systemische Risiken entstehen durch Vernetzung und begünstigen strategische Schocks. Eine einfache Ursache-Wirkungszuordnung, wie wir das im Risikomanagement gewohnt sind, ist nicht möglich. Ein sehr bekanntes Beispiel ist die amerikanische Subprime-Krise, welche nach 2007 weltweite Folgekrisen (etwa Banken-, Euro-, Wirtschafts- und Staatsschuldenkrisen) ausgelöst hat. Zu Beginn war ein Finanzprodukt, dass nicht einmal mehr durch Insider verstanden wurde und ein Risikomanagement, das die entstandenen systemischen Risiken nicht erkannte. Durch fehlende Reichweitenbegrenzungen kam es zu weitreichenden Dominoeffekten.

Der Klimawandel zählt zu den größten systemischen Risiken unserer Zeit. Siehe etwa Das Risikoparadox – Warum wir uns vor dem Falschen fürchten

Diese Seite beschäftigt sich vorwiegend mit den systemischen Risiken im Bereich der Kritischen Infrastrukturen und den möglichen gesellschaftlichen Auswirkungen. Ein wichtiger Faktor dabei sind Systeme, die als too-big-to-fail einzustufen sind.

Orientierung am Erlebten

Systemische Risiken und strategische Schocks werden auch deshalb unterschätzt, weil wir uns als Menschen an dem orientieren, was wir bereits erlebt haben. Zudem reichen unsere bisher sehr bewährten Methoden in der Risikobeurteilung für diese relativ neue Klasse von Risiken nicht mehr aus. Wobei wiederum ein sowohl-als-auch-Denken erforderlich ist. Natürlich funktionieren diese Methoden auch weiterhin für Szenarien und Ereignisse, die nicht komplexen Systemen zugeordnet werden.

Systemische Risiken und die damit möglichen strategischen Schocks treten äußerst selten auf. Sie werden aufgrund der fehlenden Evidenz mit den herkömmlichen Methoden gerne als „Restrisiken“ klassifiziert, die in der Gauß’schen Glockenkurve ganz am Rande (rot) angesiedelt sind. Die Auswirkungen können jedoch ganz erheblich oder sogar existenzbedrohend sein. Sie können daher mit den üblichen Risikominimierungsmethoden nicht kompensiert werden. Solche Schäden sind auch nicht versicherbar! Daher sprach der Soziologe Ulrich Beck bereits vor über 10 Jahren von einer „versicherungslosen Gesellschaft“, da die wirklich existenzbedrohenden Risiken nicht mehr abgedeckt werden können („Weltrisikogesellschaft„).

Wesentliche Phänomene / Kennzeichen

- Domino-, Kaskaden- oder Lawineneffekt bzw. Kettenreaktion

- Exponentielle Entwicklung

- Schmetterlingseffekt – Kleine Ursache – große Wirkung

- Schwarzer Schwan – Strategische Schocks

- Seneca-Effekt

- Sowohl-als-auch

- Strategische Schocks

- Too-big-to-fail

- Truthahn-Illusion

- Verletzlichkeit- oder Sicherheitsparadox

Too-big-to-fail – eine Gefahr für die Systemsicherheit

In diesem Beitrag werden aktuelle Beispiele für Firmenfusionen gesammelt, die zu einem System führen, das “too-big-to-fail” ist und daher eine zunehmende gesellschaftliche Gefahr darstellen.

Too big to fail: Als systemrelevant oder too big to fail (englisch: „Zu groß, um zu scheitern“) werden Unternehmen bezeichnet, die eine derart wichtige wirtschaftliche Rolle spielen, dass ihre Insolvenz nicht hingenommen werden kann. Droht diese dennoch, wird sie in der Regel mit öffentlichen Mitteln (sog. Bail-outs) abgewendet. Von besonderer Relevanz ist die „too big to fail“-Problematik für Banken, Versicherungen oder sonstige Finanzinstitute, deren Insolvenz die Stabilität des gesamten Finanzsystems bedrohen kann. Angesichts der Sonderrolle des Finanzsektors für die Realwirtschaft kann diese Insolvenz auch zu massiven Verwerfungen in der Realökonomie führen. Quelle: wikipedia

Bisher wurde dieses Phänomen vor allem im Banken- und Finanzsektor beobachtet bzw. angesprochen. Dabei spielt too-big-to-fail auch in vielen anderen Bereichen eine entscheidende Rolle, was aber noch selten so angesprochen wird. Dass es hier in den nächsten Jahren zu massiven Gegenbewegungen bzw. disruptiven Entwicklungen kommen könnte, zeichnet sich ab, wie auch die Beispiele weiter unten zeigen.

Eine Geschichte aus der rabbinischen Tradition erzählt Folgendes. Ein König, der über das Verhalten seines Sohnes erbost war, schwor, er werde ihn mit einem Felsbrocken zermalmen. Nachdem er sich beruhigt hatte, stellte er fest, dass er sich in einer Zwickmühle befand, denn ein König, der seinen Eid bricht, ist als Herrscher ungeeignet. Sein weiser Ratgeber wusste einen Ausweg: Zerschlage den Brocken in viele winzige Kieselsteinchen und bewerft damit den nichtsnutzigen Sohn. Der Unterschied zwischen tausend Kieselsteinen und einem großen Felsbrocken gleichen Gewichts ist eine gute Illustration dafür, dass Fragilität auf nichtlineare Effekte zurückzuführen ist. S. 366, Antifragilität.

Dieses Beispiel kann auch umgekehrt gesehen werden. Der Ausfall vieler kleiner Einheiten ist für die Gesellschaft bei Weitem nicht so schädlich, wie der Ausfall einer großen Einheit. Auch, wenn es ineffizienter ist.

Das europäische Stromversorgungssystem

Auch das europäische Stromversorgungssystem ist mittlerweile too-big-to-fail, auch wenn es sich hier um kein einzelnes Unternehmen handelt. Die Gefahr wird durch die Marktliberalisierung und der vorwiegenden Marktorientierung unter der Vernachlässigung von physikalischen Gesetzen und Grenzen, sowie durch die Missachtung von regionalen Rahmenbedingungen (Gestehungs- und Infrastrukturkosten) zunehmend größer. Etwa, indem Österreich zum großen Stromimporteur geworden ist, obwohl wir selber einen sehr hohen regenerativen Erzeugungsanteil haben und was dazu führt, dass noch notwendige flexible fossile Reservekraftwerke stillgelegt werden.

Wobei bei allen Beispielen ein sowohl-als-auch-Denken erforderlich und eine Effizienzsteigerung nicht per se negativ ist. Die hauptsächliche Marktorientierung führt jedoch zu einer zunehmenden Destabilisierung des Gesamtsystems. Siehe dazu etwa Stromnetze an der Belastungsgrenze, Alarm auf dem Strommarkt oder Ein robuster Strommarkt sieht anders aus.

Weitere Beispiele aus anderen Sektoren, bei denen die Gefahr entsteht, dass sie sich zukünftig disruptiv auf die Weltwirtschaft auswirken könnten:

EU genehmigte größte Fusion der Chipbranche

Die europäische Kartellbehörde hat der jüngsten Elefantenhochzeit in der US-Halbleiterbranche zugestimmt: Der Hersteller Avago darf den Konkurrenten Broadcom für 37 Milliarden Dollar (34,62 Mrd. Euro) ohne Auflagen übernehmen, teilte die EU-Kommission heute in Brüssel mit.

Es ist der bisher größte Zukauf in der zersplitterten Halbleiterbranche. Der Industriezweig wird in diesem Jahr von einer beispiellosen Übernahmewelle erfasst, weil die Unternehmen nach Einsparmöglichkeiten suchen. Treibende Kraft ist die Nachfrage nach günstigeren Chips und neuen Produkten für Geräte mit mobilem Internetempfang. Quelle: orf.at

Natürlich kann durch die Fusion auch effizienter und billiger produziert werden. Aber es entstehen auch Monopole, wie wir sie bereits aus der Softwareindustrie oder anderen Bereichen kennen. Zudem kommt es zu einer Abnahme der lebenswichtigen Diversität. Die Störanfälligkeit steigt. Kommt es zu einem Problem, steigt die Gefahr von Dominoeffekten rasant (exponentiell) an. Oder bildlich dargestellt:

Quelle: Nassim Taleb

Siehe auch den Sammelbeitrag Lieferengpässe bei wichtigen Medikamenten

Glencore: Crash-Gefahr beim größten Rohstoff-Händler der Welt

Glencore, der größte Rohstoff-Händler der Welt, befindet sich in Existenz-Gefahr: Die Aktie stürzt ab, die Kreditausfallversicherungen (CDS) haben sich in den vergangenen Monaten vervielfacht. Sollte Glencore einen Crash hinlegen, hätte das signifikante Auswirkungen auf das weltweite Finanzsystem.

Zweifel an den Erfolgsaussichten des bisherigen Sanierungskurses haben am Montag einen erneuten Ausverkauf beim Schweizer Rohstoff-Händler Glencore ausgelöst. Die Aktien brachen um 28 Prozent auf ein Rekordtief von 70,71 Pence ein. Damit summiert sich das Minus der vergangenen Monate auf etwa 75 Prozent.

Die hohe Verschuldung könnte zu einem existenzbedrohenden Problem werden, wenn sich die Rohstoffpreise nicht erholten und der Konzern nicht umfassend umgebaut werde, warnten die Analysten von Investec in einem Kommentar.

Investec warnt davor, dass bei der hohen Überschuldung von Glencore die Anleger mit einem Totalverlust rechnen müssen.

Eines der größten Probleme im Fall eines Glencore-Crashs sind die Derivate. Diese sind im Rohstoffbereich besonders wichtig. Die Derivate würden die Banken massiv treffen. Eine genaue Summe ist nicht bekannt, doch man geht davon aus, dass das Derivate-Risiko bei mindestens 70 Milliarden Dollar liegt.

Seit Monaten zeichnet sich ein Rohstoff-Schock in der Weltwirtschaft ab: Die Preise fallen bei allen wichtigen Rohstoffen faktisch ohne Unterbrechung. Ausgelöst wurde die Rohstoff-Krise durch den Absturz der Ölpreise. Dadurch entstand eine Spirale, die in ihren Folgen viel gravierender sei kann als alle bisherig bekannten Faktoren, die die Märkte destabilisieren. Quelle: deutsche-wirtschafts-nachrichten.de

An diesem Beispiel zeichnet sich bereits das hohe Schadenspotenzial von Konstruktionen ab, die too-big-to-fail sind. In der Natur hat sich daher small-is-beautiful durchgesetzt. So lange stabile Verhältnisse bestehen, funktioniert auch in der Regel alles gut. Doch ändern sich die Rahmenbedingungen, sind große Organisationen oft zu schwerfällig um flexibel und agil darauf zu reagieren. Kleine Störungen werden viel leichter verkraftet, sind diese aber größer oder länger andauernd, dann können auch Riesen ins Wanken kommen.

USA: Supermärkte rationieren Eier

Die Vogelgrippe hat in den USA Millionen Hühner getötet, Eier sind knapp und teuer geworden. Erstmals seit 2002 werden sogar Importe aus den Niederlanden erlaubt.

Rund ein Drittel der Eierprodukte, die industriell zu Lebensmitteln verarbeitet werden, sind binnen weniger Wochen wegen der Seuche vom Markt verschwunden.

Diese Krise wird durch eine Industrialisierung der Landwirtschaft verschärft, die in den USA gegenüber der in Europa vielerorts auch ziemlich intensivierten Tierhaltung noch einmal größer ist und von einer Handvoll großer Agrarkonzerne kontrolliert wird. Auf dem Geflügelmarkt gibt es als Folge einer langjährigen Oligopolisierung zusehends nur mehr große Produzenten, die Zucht, Futtermittelherstellung und Vertrieb in vertikalen Wertschöpfungsketten integrieren.

Dazu kommt, dass die amerikanische Eierproduktion in wenigen Teilstaaten konzentriert ist, allen voran in Iowa und Minnesota. Diese Marktbedingungen sorgen dafür, dass Tierkrankheiten schnell große Schäden verursachen.

Biobetriebe nicht betroffen. Kleinere und auf ökologische Kriterien setzende Eierproduzenten sind bisher von der Vogelgrippe verschont geblieben. Quelle: Die Presse

Auch hier. Große Konzentrationen sind zwar in der Regel betriebswirtschaftlicher Effizienter, jedoch führen größere Störungen zu deutlich höheren Auswirkungen (exponentielle Entwicklungen). Es steigen die systemischen Risiken und damit die Gefahr von Schwarzen Schwänen und strategischen Schocks.

Agrarriesen spielen Zusammenschlüsse durch

Unter dem Druck der niedrigen Getreidepreise könnte es im Agrarmarkt zu einer Elefantenhochzeit kommen: Der US-Großkonzern DuPont verhandelt mit dem Branchenriesen Syngenta über eine Zusammenlegung der Agrargeschäfte

Übernahmespekulationen haben am Freitag die Aktie des Schweizer Pflanzenschutz- und Saatgutherstellers Syngenta beflügelt.

Der weltweite Markt für Pflanzenschutzmittel und Saatgut wird mit Syngenta, Monsanto, Bayer, DuPont Pioneer, Dow Chemical und BASF nur von einer guten handvoll Unternehmen kontrolliert. Die Branche steht angesichts fallender Getreidepreise unter Druck .

Der US-Agrarchemiekonzern Monsanto, der für Syngenta 47 Milliarden Dollar auf den Tisch legen wollte, machte im abgelaufenen Geschäftsjahr deutlich weniger Gewinn und streicht 2600 Stellen. Quelle: www.wirtschaftsblatt.at

Der “kranke” Finanzmarkt steckt auch die Realwirtschaft an. Oder anders ausgedrückt: “Systeme, die nur dann lebensfähig sind, wenn sie permanent wachsen, sind langfristig zum Tode verurteilt – und zwar ab dem Moment, wo ein weiteres Wachstum nicht mehr möglich ist.” S. 52, Das Metanoia-Prinzip.

Mega-Schiffe – Maga-Risiken?

2014: 2.772 Schiffsunglücke weltweit, davon 75 Totalverluste Unfallhotspots: Östliches Mittelmeer und schwarzes Meer Neue Risiken: Megaschiffe und Cyberangriffe

Der langfristige Abwärtstrend bei den Schiffsverlusten hat sich 2014 mit 75 gemeldeten Großschäden weltweit fortgesetzt. Damit war das vergangene Jahr das sicherste Jahr für die Schifffahrt seit zehn Jahren.

Sicherheit auf Passagierschiffen durch Personalmangel gefährdet

Während der langfristige Abwärtstrend bei den Schiffsverlusten zuversichtlich stimmt, haben aktuelle Fährunglücke wie die der Sewol und der Norman Atlantic drei Jahre nach der Costa Concordia-Katastrophe erneut erhebliche Bedenken bezüglich der Qualität von Trainings- und Notfallmaßnahmen auf Passagierschiffen ausgelöst.

In vielen Fällen ist die Konstruktion der Schiffe nicht der einzige Schwachpunkt, wie die Studie zeigt: Die beiden Fährunglücke decken besorgniserregende Defizite bei der Notfallvorbereitung der Besatzungen von Autofähren und Passagierschiffen auf. Eine nur Minimalanforderungen genügende Personalstärke lässt nach Ansicht der AGCS-Experten kaum Spielraum für Schulungen an Bord und sollte daher nicht zur allgegenwärtigen Praxis auf Schiffen werden.

Ausblick: Megaschiffe und Hackerangriffe als neue Risiken

Die Branche sollte sich laut Studie für die Zukunft auf Großschäden von über 1 Mrd. US-Dollar einstellen, insbesondere wenn große Containerschiffe oder schwimmende Offshore-Anlagen beteiligt sind. Das maximale Risiko in diesem Zusammenhang betrifft nicht nur die Schäden an Schiff und Fracht, sondern auch Umweltschäden oder Betriebsunterbrechungen. Megaschiffe können nur wenige Tiefwasserhäfen ansteuern, zudem bestehe weltweit ein Mangel an qualifizierten Fachkräften. Die Bergung und Beseitigung von Schiffen ist ebenfalls eine Herausforderung. Wie die Bergung des Wracks der Costa Concordia zeigt, können die Kosten leicht ein Vielfaches des Kaskowerts des Schiffes betragen.

Zusätzlich stellen Cyberrisiken eine weitere neue Gefahr für die Schifffahrtindustrie dar, die stark vernetzt ist und zunehmend auf Automatisierung setzt. Künftig könnten Schiffe und Häfen zu verlockenden Zielen für Hacker werden. Ein Cyberangriff auf die Technik an Bord, insbesondere auf die elektronischen Navigationssysteme, könnte zu einem Totalverlust führen oder sogar mehrere Schiffe einer Reederei betreffen. Andere Szenarien sind zum Beispiel Cyberangriffe auf große Häfen, die Terminals außer Betrieb setzen oder Containerladungen oder vertrauliche Daten manipulieren. Solche Angriffe könnten zu erheblichen Betriebsunterbrechungsschäden oder zu Reputationsverlusten führen.

Weitere Schifffahrtsrisiken aus der “Safety and Shipping Review 2015”:

“Blindes” Vertrauen auf elektronische Navigation: Die Kollision des Containerschiffs Rickmers Dubai mit einem unbemannten Kranschiff im Jahr 2014 zeigt die Gefahren von automatisierter E-Navigation auf. Schulungsstandards für Systeme wie das Electronic Chart Display & Information System (ECDIS) sind uneinheitlich. “Offiziere benötigen eine solide Ausbildung, um Fehlinterpretationen von ECDIS und Bedienfehler zu vermeiden, die zu teuren Katastrophen führen können. Darüber hinaus sind manuelle Navigationsinstrumente und -fähigkeiten weiterhin unverzichtbar”, so Khanna. Quelle: www.ots.at und www.risknet.de

Größere Schiffe führen zur Risikokonzentration

Anbei finden Sie einige relevante Informationen und Statistiken des Schifffahrtversicherers Allianz Global Corporate & Specialty (AGCS), die im Zusammenhang mit der Evakuierung der Viking Sky von Interesse sind. Generell sei angemerkt, dass Schiffsverluste in den letzten zehn Jahren um mehr als ein Drittel (38 Prozent) zurückgegangen sind, was auf ein verbessertes Schiffsdesign, neue Technologie und Fortschritte im Bereich Risikomanagement und Sicherheit zurückzuführen ist. Es kommt jedoch weiterhin zu Unglücken, wie das Beispiel der „Viking Sky“ zeigt. Quelle und weitere Details: www.risknet.de

Hier verbirgt sich ein klassischer Schwarzer Schwan sowie das Verletzlichkeitsparadox. Durch die steigende Effizienzsteigerung (weniger Personal, größere Schiffe) steigt jedoch auch der Schaden bei einem Zwischenfall. Die zunehmende Digitalisierung führt zudem zur steigenden Gefahr von Cyber-Angriffen. Aber es muss nicht immer ein Angriff sein – auch Softwarefehler oder -ausfälle können zu weitreichenden Folgen führen. Aus systemischer Sicht durchaus zu hinterfragende Entwicklungen. Darüber hinaus stellt sich die Frage, was passiert, wenn die kleineren Schiffe/Rederei unrentable werden und vom Markt verschwinden und es dann zu einem wirtschaftlichen Einbruch kommt. Sind dann die Großschiffe auch noch rentable zu betreiben, oder muss dann einfach der Kunde die Kosten für das Wachstum schlucken? Wir werden es wahrscheinlich noch erfahren.

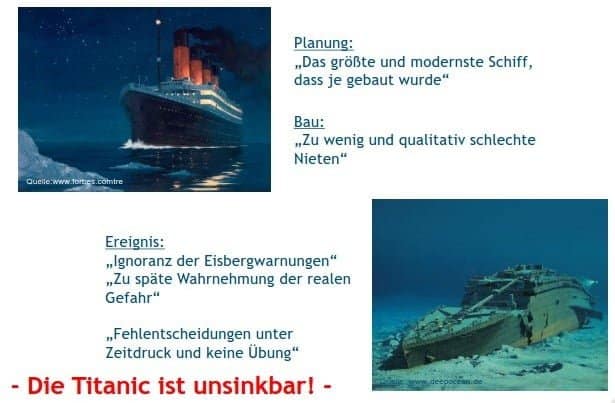

Truthahn-Illusion - Rückspiegel-Effekt - Titanic-Phänomen

Truthahn-Illusion

Ein Truthahn, der täglich von seinem Besitzer gefüttert wird, geht aufgrund seiner täglichen positiven Erfahrung (Fütterung und Pflege) davon aus, dass sein Besitzer es gut mit ihm meint. Ihm fehlt die wesentliche Information, dass diese Fürsorge nur einem Zweck dient: dem späteren Festmahl. Am Tag vor «Thanksgiving», an dem (in den USA) traditionell die Truthähne geschlachtet werden, erlebt der Truthahn die fatale Überraschung seines jähen Endes. Diese Metapher beschreibt den häufigen Umgang mit Ereignissen, die sehr selten sind, aber enorme Auswirkungen haben.

Rückspiegel-Effekt

Beim Autofahren ist uns das sofort klar, da haben wir den Überblick. Beim europäischen Stromversorgungssystem, mit vielen Fahrern und Beifahrern, ist das leider nicht so klar. Bereits heute ist die volle Aufmerksamkeit des Netzsteuerungspersonals gefordert, um auch mit möglichen kritischen Situationen fertig zu werden. Das machen sie auch hervorragend. Aber es wird immer schwieriger, trotz technischer Unterstützungsmöglichkeiten, die es vor wenigen Jahren noch gar nicht gab.

Titanic-Phänomen

Eine weitere Beschreibungsmöglichkeit ist das Titanic Phänomen. Auch die Titanic galt als unsinkbar, wie dies der Kapitän vor der ersten Fahrt ausgedrückt hat: „Ich kann mir keine Situation vorstellen, die ein Schiff zum Sinken bringen könnte. Ich halte es für unmöglich, dass dieses Schiff ernsthaft beschädigt werden könnte. Dazu ist der moderne Schiffsbau schon zu weit fortgeschritten.“ Captain: John Edward Smith

Quelle: http://www.zukunftsforum-oeffentliche-sicherheit.

Edward John Smith, sagte als Kommandant der Adriatic im Jahr 1907 nach deren Jungfernfahrt, dass der Schiffbau zu seinen Lebzeiten so perfekt sei, dass eine absolute Katastrophe, in die die Passagiere eines großen modernen Linienschiffs verwickelt werden könnten, völlig undenkbar sei. Was auch immer geschehe, es bleibe genug Zeit, um das Leben aller Menschen an Bord zu retten, bevor das Schiff sinke.

Verletzlichkeits- oder Sicherheitsparadox

Dieses Phänomen beschreibt den Widerspruch zwischen Risikowahrnehmung und Realität. Durch das gute Funktionieren nehmen die Handlungskompetenzen, um mit Störungen umgehen zu können, ab. Im betriebswirtschaftlichen Umfeld neigt man durch den generell steigenden Kostendruck zu ungesunden “Effizienzsteigerungen”, wo “totes Kapital” eingespart wird. Das betrifft mittlerweile in vielen Bereichen für die Systemsicherheit unverzichtbare Reserven und Redundanzen. Dadurch nimmt die Störsicherheit ab und die Verwundbarkeit steigt. Dieses Phänomen betrifft mittlerweile fast alle Lebensbereiche. Siehe dazu auch Schwarmdumm – So blöd sind wir nur gemeinsam oder Wenn betriebswirtschaftliche Optimierungen systemgefährdend werden.

Penrose-Dreieck – Tobias R. – Wikipedia

Vernetztes Denken

- auf einer bestimmten Betrachtungsebene in Zusammenhängen zu denken,

- relevante externe Einflüsse zu berücksichtigen,

- Zielkonflikte zu erkennen und bewusst zu optimieren sowie

- zielorientiert zu handeln.

Grundsätzlich wird damit eine Abkehr von “der Konzentration auf das Wesentliche” bzw. der isolierten Betrachtung/Analyse von Einzelelementen („Silodenken“) angestrebt, wenngleich auch hier eine sowohl-als-auch-Betrachtung erforderlich ist. Die Kunst besteht darin, zu erkennen, wann bzw. in welchem Kontext welche Methode sinn- und wirkungsvoll ist.

Vernetztes Denken” bedeutet die Erfassung von Mustern, Beziehungen, Zusammenhängen und (Wechsel-)Wirkungen zwischen Systemelementen.

Ziel ist es “unsichtbare Fäden” zu erkennen und zu adressieren, was durch die steigende Vernetzung eine immer größere Herausforderung wird. Darüber hinaus ist zu beachten, dass unter Stress nur spontan intuitives Denken möglich ist und das rationale Denken blockiert wird. Die Sinnesorgane fokussieren evolutionär nur noch punktuell auf die Beute, den Feind oder die Gefahr. Es entsteht der Tunnelblick. Dabei überfordert Komplexität grundsätzlich das menschliche Gehirn, egal ob es mehr oder weniger komplex ist (siehe dazu etwa Komplexität im Management von Maria Pruckner). Daher sind Hilfsmittel, wie etwa die Visualisierung von Zusammenhängen notwendig, da unser Gehirn nur die Wechselwirkungen von 3-4 Faktoren ohne Unterstützung erfassen kann. Damit kann ein Abbild der Realität geschaffen bzw. die Einschränkung auf einzelne Aspekte (“Silodenken”) vermieden werden.

Grafik: Frederic Vester

„Unsichtbare Fäden“

Ein anderes Beispiel ist, wenn man ein Kuchenrezept und alle Zutaten hat, bedeutet das noch lange nicht, dass der Kuchen auch gut wird. Das Selbe gilt für ein Orchester.Frederic Vester hat den Begriff der “unsichtbaren Fäden” geprägt. Damit soll zum Ausdruck gebracht werden, dass es in Systemen vor allem auf die “Beziehungen” zwischen den Systemelementen und weniger auf die einzelnen Elemente selbst ankommt und dass wir diese gerne vernachlässigen, wie viele praktische Beispiele zeigen. In unserem Hirn gibt es Milliarden von Nervenzellen. Die Gedankenleistung hängt aber nicht so sehr von den Nervenzellen, als vielmehr von den Verbindungen ab. Entscheidend ist die Qualität der Beziehungen!

Das Ganze ist mehr als die Summe seiner Teile.

Analytischer vs.Systemansatz – Zwei Ansätze zur Erfassung der Wirklichkeit

Da der Mensch vorwiegend linear und monokausal denken möchte, wird die Problembewältigung mit traditionellen Wissensschemata in einer dynamischen Umwelt (VUCA) immer schwieriger. Komplexität und die Dynamik machen uns zu schaffen. Das Gefühl der Überforderung stellt sich ein.

Systemische Betrachtung

Bei einer systemischen Betrachtung wird im Gegensatz zu einer Analyse ein System nicht in seine Einzelteile zerlegt und dann analysiert und wieder zusammengsetzt, sondern versucht, die Zusammenhänge zu beschreiben. Dies auch deshalb, da sich komplexe Systeme nicht in ihre Einzelteile zerlegen und dann wieder zusammensetzen lassen. Eine systemische Betrachtung adressiert die “unsichtbaren Fäden” und Wechselwirkungen zwischen den Systemelementen. Wesentlich ist dabei, dass nicht eine “Konzentration auf das Wesentliche” erfolgt, sondern “das ganze Muster erfasst” wird. Siehe auch Resilienz.

Unser Denkrahmen

Wir alle sind durch unser Umfeld und durch unsere Geschichte geprägt und haben dadurch einen gewissen Denkrahmen aufgebaut, der sich gut mit nachfolgendem Beispiel darstellen lässt. Die Aufgabe besteht darin, 9 quadratisch angeordnete Punkte mit einem Stift durch vier gerade Linien zu verbinden, ohne den Stift abzusetzen. Sollten Sie die Lösung nicht finden, klicken Sie einfach auf das Bild.

In Experimenten wurde die Herangehensweise von Versuchspersonen an dieses Problem untersucht. Versuchspersonen, die diese Aufgabe lösen, brauchen oft sehr lange, bis sie zu einer Lösung des Problems gelangen. Dies liegt daran, dass Personen oft dazu neigen, zusätzliche Einschränkungen bei der Lösung von Problemen vorzunehmen. Beispielsweise versuchen Versuchspersonen oft, beim Zeichnen der Striche nicht das Quadrat zu verlassen. Erst wenn diese Einschränkung aufgegeben wird, ist eine Lösung des Problems möglich, indem man über das Quadrat hinaus zeichnet. Das Neun-Punkte-Problem ist somit ein gutes Beispiel für den englischen Begriff thinking outside the box (zu deutsch etwa: außerhalb des vorgegebenen Rahmens denken) oder des im deutschen gebräuchlichen Über den Tellerrand schauen, der im Bereich des Problemlösens eine wichtige Rolle spielt. Quelle: Wikipedia

Dieses Beispiel dient auch dazu, klar zu machen, dass wenn man ein neuartiges Problem lösen möchte (“Innovativ sein will/muss”), man den bestehenden Denkrahmen verlassen muss. Etwa, indem bestehende Konventionen und Regeln gebrochen werden. Nur so kann sich etwas Neues entwickeln. Zum anderen sind bei unkonventionellen Problemen oder in einer Katastrophensituation (“Blackout”) unkonventionelle Lösungen und Herangehensweisen notwendig.

VUCA - Volatilität, Unsicherheit, Komplexität und Ambiguität

Die Abkürzung VUCA steht für Volatility, Uncertainty, Complexity und Ambiguity also Volatilität, Unsicherheit, Komplexität und Ambiguität und wird in Managementkreisen für die Beschreibung der aktuellen Entwicklungen/Zeit herangezogen.

- Volatilität (volatility) beschreibt die Schwankungsintensität und -breite über den zeitlichen Verlauf. Dieser Begriff wird auch häufig im Zusammenhang mit der fluktuierenden Einspeisung von Windstrom- und PV-Anlagen verwendet, wo es innerhalb kürzester Zeit zu erheblichen Schwankungen kommen kann, was die Netzsteuerung zunehmend herausfordert.

- Unsicherheit (uncertainty) beschreibt die Nicht-Vorhersagbarkeit von Ereignissen (siehe auch Das Unerwartete managen)

- Komplexität (complexity) wird durch die Anzahl von Einflussfaktoren und deren gegenseitiger Abhängigkeit (Vernetzung und „unsichtbare Fäden„) bzw. Interaktion beeinflusst. Je mehr Interdependenzen (wechselseitige Abhängigkeiten) ein System enthält, desto komplexer ist es. Der Begriff „komplex“ ist dabei vom Begriff „kompliziert“ zu differenzieren – auch wenn beide oft fälschlicherweise äquivalent benutzt werden. Ein kompliziertes System kann man vereinfachen, ohne die interne Struktur des Systems zu zerstören (Beispiel: ein unübersichtlicher mathematischer Bruch wird durch Kürzen vereinfacht). Ein komplexes System hingegen wird zerstört bzw. es entsteht etwas Neues, wenn man versucht, dieses zu vereinfachen – z.B. durch Zerlegen (siehe auch Emergenz). Der Organisationspsychologe Peter Kruse dazu:

- Ambiguität (ambiguity) beschreibt die Mehrdeutigkeit oder auch Widersprüchlichkeit einer Situation oder Information. Daher gibt es nicht nur eine Wahrheit oder Wirklichkeit, sondern viele. Daher stellt ein Sowohl-als-auch-Denken einen wichtigen Beitrag zum Umgang mit Ambiguität dar.

Die Wiener Kybernetikerin Maria Pruckner bezeichnet den Begriff nicht zu Unrecht als Marketingbegriff:

Aber VUCA klingt einfach besser. Was macht es schon, wenn volatility, uncertainty, ambiguity im selben Atemzug mit complexity genannt werden, obwohl dies nur untergeordnete Eigenschaften von complexity sind.

FOLGEN SIE MIR

Zuletzt aktualisiert am 21. Juni 2024 um 11:10